はじめに

タイトルの通りです。

Mac mini m4 Proを買いました。

用途はローカルLLMでDeepSeekを利用するためです。

LLM市場はまだまだ発展の余地があって、性能はどこも伸び盛りなので、用途に応じて使い分けていきたいですが。

これを機に、LLMを通して世の中の仕組みをより知っていき、QoLを一段と高めていきたいです。

結論

LM Studioをインストールして、DeepSeek-R1-disrillを使ってみた結果、

LM Studioを使えば、簡単にローカルLLM環境が楽しめました。

今度はAIエージェントでローカルLLMを利用して、簡単なアプリケーションを作成してみようと思います。

手順

以下の記事を参考にしました。

0. Mac mini m4 Proを買う

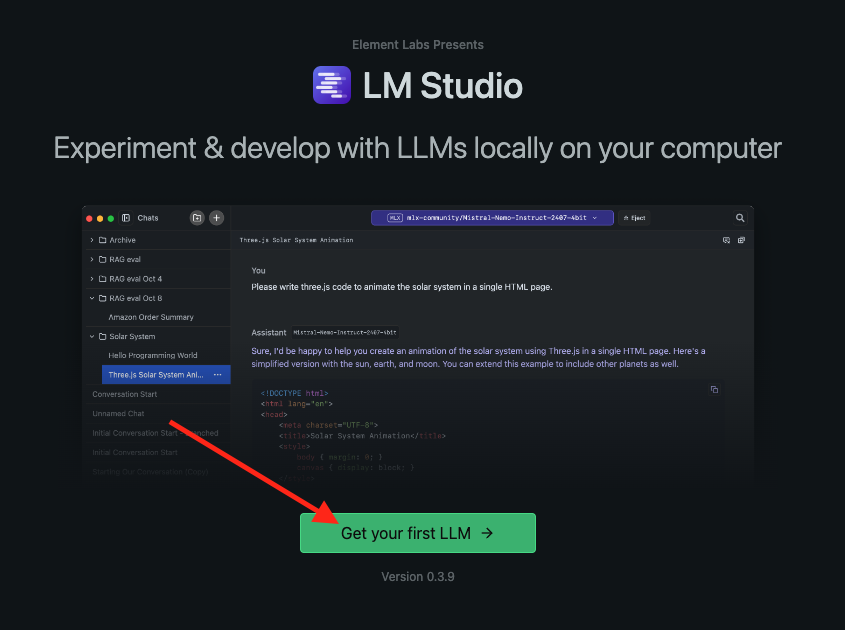

1. LM Studioをインストール

ダウンロードしたら、起動する。

ローカルマシンでヘッドレスサーバとして利用する場合はチェック。

ダウンロード中。

ダウンロード完了。

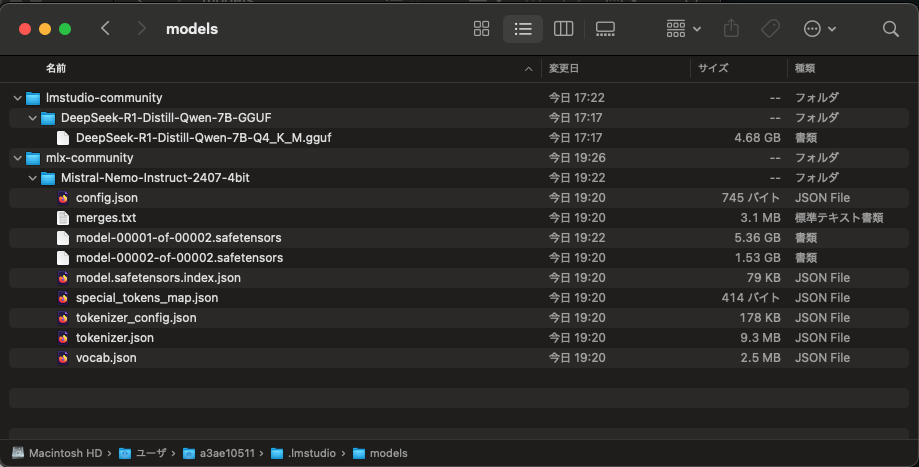

モデルは以下のディレクトリに保存される。

/Users/ユーザー名/.lmstudio/models

モデルのロードが完了した。

2. チャット

DeepSeek(DeepSeek-R1-Distill-Qwen-7B-Q4_K_M.gguf)

よく話題になるやつ。

中国の一部らしいです。

ちなみに1秒くらいで出力されました。

思っていたよりかなり早い印象です。

Mistral-Nemo-Instruct-2407-4bit

MLXフレームワークでの12Bのモデルでも実行してみました。

メモリ使用率は上記のとおりです。

参考

主要なLLM

米MetaのLlamaシリーズ、米GoogleのGemmaシリーズ、米MicrosoftのPhiシリーズ、中国DeepSeekのDeepSeek R1 Distillシリーズ、中国AlibabaのQwenシリーズなど。